Spain, Ago 19, 2023

La calidad de los datos es un claro desafío de cualquier organización actual. Porque, a medida que aumenta su volumen, se vuelve más decisivo que esta información sea de calidad y aporte el máximo valor al negocio. Tomar mejores decisiones comerciales y ganar ventaja competitiva depende de ello.

La propuesta de IBM Data Observability by Databand responde a esta necesaria búsqueda de datos fiables y rigurosos que extraigan más valor de realidades modernas, como la inteligencia artificial a gran escala.

Se trata de una plataforma de software que permite a las organizaciones controlar la calidad de sus datos, procesar sus metadatos de canalización, incluidos registros, información de tiempo de ejecución y perfiles de datos a partir de otras fuentes, como Airflow, Spark y Snowflake. De esta forma, los científicos de datos pueden detectar los cuellos de botella o las anomalías, así como las razones potenciales por las que se producen.

Es decir, se trata de acceder a una visión completa y profunda de todos los entornos, para adelantarse y reaccionar a cualquier anomalía que pueda afectar a la calidad de los datos.

Según un informe de Statista, el mercado de la observabilidad y calidad de datos es uno de los más pujantes en el sector tecnológico. Las organizaciones quieren controlar y proteger los datos a toda costa y se estima que este mercado supere a escala global los 20.000 millones de dólares en 2024, en gran medida por el impulso a tareas de Inteligencia artificial, automatización y Cloud.

IBM Data Observability de Databand hace frente a este desafío y pone al alcance de las organizaciones tecnología que investiga posibles fallos que afectan a la calidad de sus datos, alertando ante cualquier incidencia que pueda perjudicarla. Además, aporta visibilidad de estos datos -y metadatos- y de su correcto uso, pero también brinda métricas que analizan su calidad de forma continua y personalizada. Para ello, incluye una interfaz de usuario, intuitiva y basada en la web, que monitoriza todos los flujos de datos y alerta de cualquier incidente peligroso.

Así, pone el foco en los servicios de almacenamiento, análisis, visualización y alerta, para que todos los flujos de datos y metadatos, de toda índole, sean correctos y no contengan errores que perjudiquen las tareas cotidianas, incluso con métricas específicas de esta calidad.

Para ello, incluye varios componentes: una biblioteca de Python, la interfaz de línea de comandos que se utiliza para crear los flujos y recopilar los metadatos, un almacén para estos metadatos, una interfaz de usuario web para observar y controlar proyectos y un motor de alertas y detección de anomalías.

Se trata de supervisar los datos en movimiento, registrar y guardar metadatos de las operaciones del código y de su canalización. En otras palabras, cualquier información a nivel de sistema, aplicación, proceso gráfico o nivel de datos relevante para el funcionamiento normal de los científicos de datos, tan en el punto de mira en los últimos tiempos.

Related Insights

Spain , Apr 22, 2024

La inteligencia artificial que aplica al negocio Watsonx

La plataforma de datos e inteligencia artificial IBM® Watsonx es la moderna aportación a un deseo antiguo de las organizaciones: aprovechar o, incluso, rentabilizar sus propios datos.

Spain , Apr 12, 2024

Oracle sobre IBM Power: los 5 cinco pilares de un binomio ganador

El diseño combinado del sistema operativo AIX en servidores Power con la tecnología IBM PowerHA® puede brindar a los clientes un tiempo de actividad impresionante y la capacidad de administrar y monitorizar la disponibilidad, para prevenir tanto las interrupciones planificadas como no planificadas.

Spain , Feb 14, 2024

Los principales desafíos de seguridad vienen con la revolución 5G

La llegada del 5G está provocando una explosión de nuevas oportunidades de negocio y de importantes avances e innovaciones tecnológicas.

Spain , Feb 14, 2024

¡La operación Multinube está en vivo! ¿Cómo mantenerla funcionando?

El partner que ha estado trabajando desde el comienzo de este viaje, con evaluación de peso, además de todas las evaluaciones, orientación y provisión de tecnologías, también ayuda a configurar las estructuras Cloud Center Office Excellence (CCoE).

Spain , Feb 14, 2024

FinOps: uniendo finanzas, tecnología y negocios en la nube

FinOps, sin duda, es una cultura enfocada a la práctica de la responsabilidad financiera, considerando los gastos variables de la nube, en la que debe haber colaboración entre equipos, información fluida, a través de informes accesibles y actualizados, en la que todos son responsables por su consumo en la nube.

Spain , Feb 14, 2024

Modernización, aplicaciones y colaboradores, los tres ejes de la migración al cloud

Las arquitecturas digitales que permitan el despliegue de aplicaciones son el presente y el futuro. La nube es y seguirá siendo un eslabón fundamental para las empresas.

Spain , Feb 14, 2024

Los cimientos digitales sólidos son la clave para la agilidad empresarial

Los sistemas Legacy ya no brindan la base para la infraestructura de TI de una empresa moderna. Se requiere una base digital moderna para mejorar y potenciar las tres S: seguridad, escalabilidad y sustentabilidad.

Spain , Feb 9, 2024

Éxito probado en proyectos emblemáticos

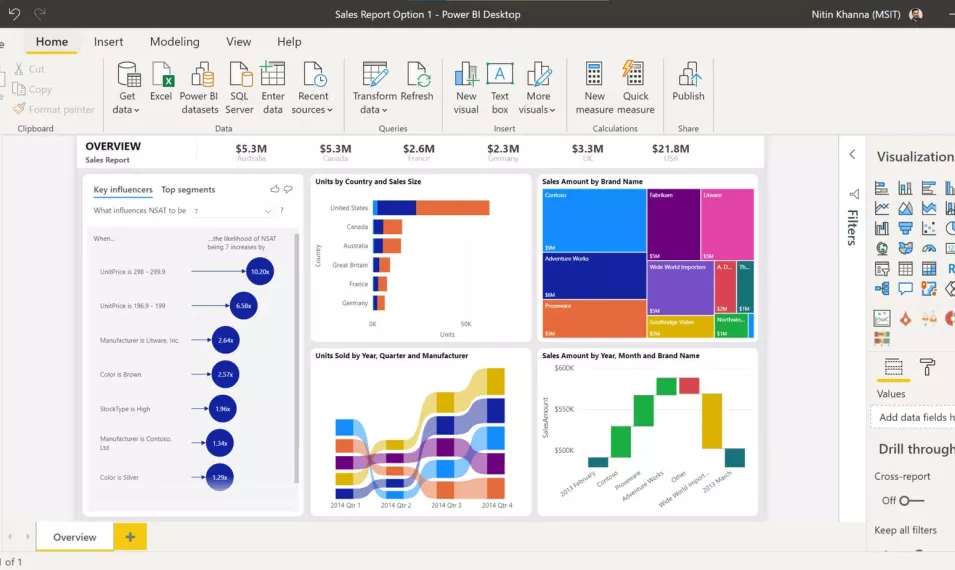

Microsoft Power BI una alternativa tecnológica asequible, con una versión desktop gratuita que permite a casi cualquier negocio poder acceder a su funcionalidad.

Spain , Jan 22, 2024

VMWARE CLOUD FOUNDATION

VMware by Broadcom es el resultado de la unión de dos equipos líderes en el mercado que se unen con el objetivo de constituir la principal compañía de infraestructura del mercado.

Spain , Dec 18, 2023

Ármate frente a cualquier vulnerabilidad o ataque con Microsoft

Se debe poner el foco en las aplicaciones, el correo electrónico, las herramientas de colaboraciones, los equipos finales, las soluciones de SaaS, la identidad, entre otros puntos.

Spain , Dec 15, 2023

WatsonX abre un universo inteligente a la atención de clientes

La comprensión del lenguaje natural (NLU) incorporada en IBM Watson Assistant incluso permite que los equipos de atención al cliente construir un sistema robusto, inteligente y sencillo.

Spain , Dec 14, 2023

La respuesta: IBM Planning Analytics with Watsonx

IBM® Planning Analytics with Watson busca la excelencia en la planificación empresarial y viene a romper los tradicionales silos en los que se alojaban estas tareas.

Spain , Dec 12, 2023

7 grandes beneficios de IBM® Planning Analytics with Watson

Las grandes ventajas de las modernas tecnologías de planificación y análisis de IBM pueden resumirse en siete beneficios principales de IBM® Planning Analytics with Watson.

Spain , Dec 12, 2023

De la ciber seguridad a la ciber resiliencia, en 6 pasos

Hablamos de una metodología de seguridad para una recuperación rápida frente a cualquier ciberataque.

Spain , Dec 5, 2023

Acelerar la transformación digital con AIOps

Las llamadas soluciones de AIOps, inteligencia artificial aplicada a las operaciones IT, cumplen este cometido e introducen proactividad a la operativa.

Spain , Dec 4, 2023

La amenaza fantasma del ransomware

El software IBM Security® QRadar® utiliza inteligencia artificial y otras tecnologías para monitorear e inspeccionar los datos generados por el sistema de IT.

Spain , Dec 4, 2023

WatsonX, la inteligencia líder según Gartner

Los líderes como IBM están en la posición más fuerte para influir en la dirección del mercado, demuestran una visión que define la oferta y la demanda de la inteligencia artificial conversacional.

Spain , Nov 29, 2023

Modernas plataformas de planificación y análisis de datos

Los beneficios de las plataformas modernas de planificación y presupuesto son innumerables e incluyen desde proporcionar una plataforma única de datos hasta respaldar sólidas capacidades.

Spain , Nov 28, 2023

Vía libre a la ciber resiliencia

Por todo ello, es necesario contar con la mejor tecnología de resiliencia de IBM y la larga experiencia en este campo de un integrador como Logicalis, para guiarle en este camino.

Spain , Nov 28, 2023

La relación entre aplicación e infraestructura, en toda su extensión

Turbonomic adopta un enfoque diferente y genera acciones, no recomendaciones. Ejecuta órdenes en tiempo real.

Spain , Nov 23, 2023

El rendimiento de las aplicaciones, a escena

Instana y Turbonomic, acceden a una capacidad de observación completa de todas nuestras aplicaciones, con analítica y gestión inteligente de los recursos que estas necesitan para lograr sus más altas cotas de rendimiento de las aplicaciones corporativas.

Spain , Nov 23, 2023

¿Podemos hablar con las máquinas? Elemental, querido Watson

Lo dice el cuadrante mágico de Gartner: IBM es líder en lenguaje de proceso natural e IA con Watson X.

Spain , Nov 20, 2023

Planificación y análisis, cuestión de supervivencia

El software de planificación permite a las organizaciones hacer ambas cosas, más rápido y eficazmente que si se utilizan simples hojas de cálculo, por eso es un software tan popular y ha ganado tanta inercia.

Spain , Nov 20, 2023

Ciber resiliencia, la hora de la verdad

Para los responsables de IT, la ciber resiliencia es un aspecto vital, pero el resto de la organización debe alinearse con esta necesidad.

Spain , Nov 17, 2023

Un entorno único de storage para competir en el exigente mercado actual

IBM® Storage Scale System es la forma más fácil y sencilla de instalar, actualizar y escalar los recursos informáticos de cualquier organización, ofreciendo una experiencia de cliente más ágil y eficiente.

Spain , Nov 16, 2023

Autopista hacia el futuro de la informática empresarial

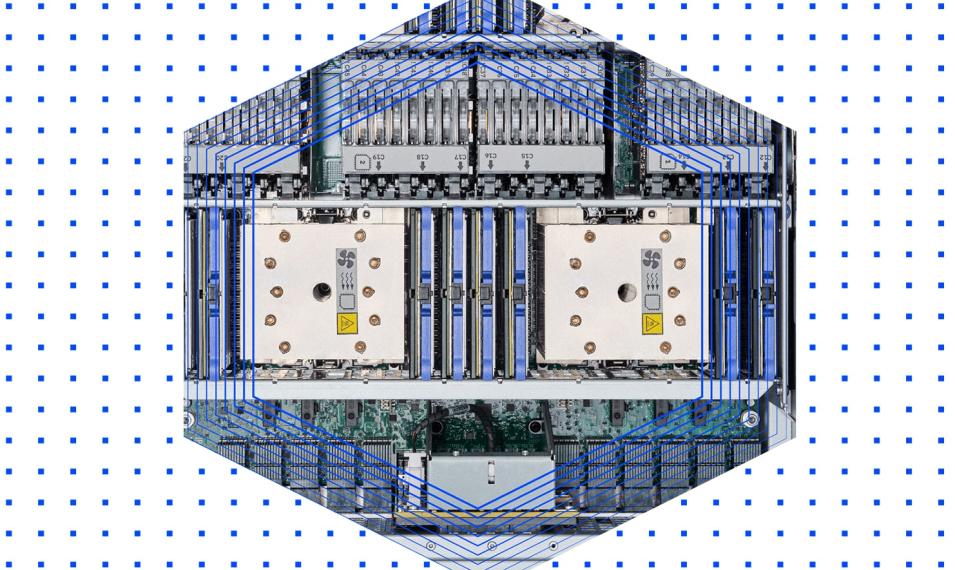

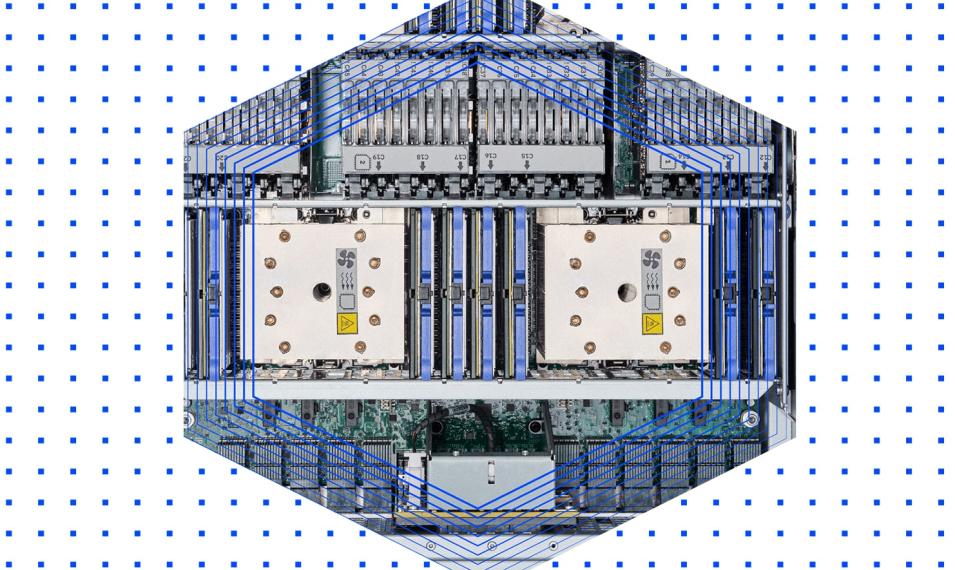

Mayor rendimiento, escalabilidad, seguridad y eficiencia energética,o que supone un problema de gran calado que solo el avance tecnológico como IBM Power10.

Spain , Oct 24, 2023

La importancia en la elección del partner de seguridad adecuado

Logicalis gracias a AWS ofrece una variedad de herramientas y servicios que pueden ayudar a proteger a las organizaciones de estos ataques.

Spain , Oct 19, 2023

7 cualidades imbatibles de IBM Storage

Descubre cómo IBM Storage Scale puede ayudarte a gestionar el crecimiento de tus datos con eficiencia y escalabilidad.

Spain , Oct 19, 2023

Entra en la nueva era de la informática, con IBM Power10

Mayor rendimiento, escalabilidad, seguridad y eficiencia energética,o que supone un problema de gran calado que solo el avance tecnológico como IBM Power10.

Spain , Oct 17, 2023

Cómo observar el ciclo completo de sus datos

IBM® Data Observability by Databand permite conocer la “salud” de todas las canalizaciones de datos y garantizar que se ejecutan los procesos de forma correcta.

Spain , Sep 21, 2023

Todo el Storage, en la misma tela de araña

Descubre cómo IBM Storage Scale puede ayudarte a gestionar el crecimiento de tus datos con eficiencia y escalabilidad.

Spain , Sep 18, 2023

El doble de potencia y prestaciones, con IBM Power10

IBM proporciona a todos ellos los servidores basados en procesadores Power10 más potentes del mercado, en variantes de escalamiento horizontal o vertical para ajustarse a la mayoría de los entornos actuales.

Spain , Sep 13, 2023

Próximo reto de la empresa moderna: mejorar la calidad de sus datos

IBM® Data Observability by Databand permite conocer la “salud” de todas las canalizaciones de datos y garantizar que se ejecutan los procesos de forma correcta.

Spain , Sep 13, 2023

Logicalis Spain recibe la competencia en Storage de AWS

Logicalis Spain ha recibido la Competencia en Storage de AWS que, sumando al Partnership Advanced AWS.

Spain , Jun 8, 2023

IBM Power 10 y las prioridades tecnológicas de la empresa actual

La mayoría de las empresas actuales (44,4%) se encuentra en una fase avanzada de su proceso de modernización, frente al 10% que se encuentra en una etapa inicial o el 8,3% que se considera en el tramo final.

Spain , Jun 1, 2023

La respuesta de un líder para construir entornos multicloud

Las soluciones de IBM Spectrum, Scale y Protect llevan años liderando los modernos entornos multicloud de grandes compañías en todo el mundo.

Spain , May 30, 2023

Agilidad de desarrollo y despliegue en contenedores con total seguridad

Mejore su resiliencia corporativa, poniendo las bases para evitar ciberataques y almacenando de forma segura los datos de sus contenedores en los sistemas IBM Spectrum Protect.

Spain , May 23, 2023

IBM Storage Scale: la solución de almacenamiento escalable para empresas

IBM Storage Scale es una solución de almacenamiento escalable que ayuda a las empresas a gestionar grandes cantidades de datos de manera eficiente y a reducir costos.

Spain , May 12, 2023

Modernice su infraestructura con Red Hat OpenShift en IBM Power 10

Red Hat OpenShift en IBM Power 10 ofrece una solución de nube híbrida que puede soportar cargas de trabajo críticas y proporcionar una infraestructura firme.

Spain , May 11, 2023

Cloud de AWS te puede proteger de un ataque de ransomware

Logicalis gracias a AWS ofrece una variedad de herramientas y servicios que pueden ayudar a proteger a las organizaciones de estos ataques.

Spain , May 11, 2023

Logicalis moderniza los procesos de Àltima Serveis funeraris con AWS

Altima Serveis Funeraris, ha llevado a cabo una transformación en su estrategia de copias de seguridad en colaboración con Logicalis y la tecnología de AWS.

Spain , May 10, 2023

Backup en Cloud con AWS mejora la arquitectura de su empresa

La Cloud de AWS ofrece una amplia gama de servicios de backup que permiten a las empresas proteger sus datos de forma eficiente y segura con herramientas como AWS Backup, Amazon S3 Glacier y AWS Storage Gateway.

Spain , May 10, 2023

Restauración de datos en entornos híbridos con AWS Backup

AWS Storage Gateway permite crear una caché intermedia en las instalaciones del cliente que hace de puente entre las apps on-prem y S3.

Spain , May 3, 2023

AWS FSX for NetApp ¿Cómo aplicarlo a su organización?

AWS FSx for NetApp es una solución conjunta de Amazon Web Services (AWS) y NetApp que proporciona un servicio de almacenamiento de archivos en la nube.

Spain , May 3, 2023

Ventajas de AWS FSX for NetApp

AWS FSx for NetApp es una solución conjunta de Amazon Web Services (AWS) y NetApp que proporciona un servicio de almacenamiento de archivos en la nube.

Spain , Apr 23, 2023

Cómo sentar las bases del edificio “Digital First”

Cualquier empresa o entidad convive ahora mismo con muy distintos entornos de sistemas, datos y aplicaciones, en un entramado que debe replantearse para responder a un mundo “Digital First”.

Spain , Apr 21, 2023

IBM Storage Fusion mejora la eficiencia y la productividad en la gestión de datos empresariales

Descubra las soluciones de almacenamiento de datos empresariales de IBM con Storage Fusion.

Spain , Apr 6, 2023

3 formas en la que los CIO están transformando sus organizaciones hacia cero emisiones

El informe Global CIO 2023 de Logicalis ofrece un análisis profundo sobre cómo los líderes tecnológicos pueden impulsar la sostenibilidad mediante los 3 pilares de ESG (ambiental, social y gobernanza).

Spain , Apr 5, 2023

Como los CIOs construyen resilencia mediante servicios gestionados

La Encuesta Global CIO 2023 de Logicalis destaca que más de la mitad de los CIO (52%) están aumentando el gasto en gestión de riesgos y planean hacer crecer sus equipos de gestión de riesgos este año.

Spain , Apr 4, 2023

Recibimos la certificación Advanced de CyberArk

Logicalis Spain ha recibido la acreditación de partner Advanced EMEA de CyberArk después de un trabajo intenso con el equipo y las tecnologías de Cyber Ark.

Spain , Mar 28, 2023

Power 10 de IBM: el futuro de la computación empresarial

El Power 10 de IBM está liderando el camino hacia la próxima generación de computación empresarial.

Spain , Nov 3, 2021

La importancia de promover la innovación para garantizar la seguridad

La rápida digitalización implica que las empresas deben mejorar la ciberseguridad para adelantarse tanto a la competencia como a los ciberdelincuentes.

Spain , Jan 18, 2021

Proteja el activo más importante de su empresa: sus empleados

Los empleados merecen el apoyo de la empresa, ya que ayudaron a impulsar el negocio durante un año difícil. Han estado bajo una gran presión, así que ahora es el momento de que las empresas practiquen el liderazgo empático y adopten un enfoque más humanista. Lo que dicen los directivos, cómo lo transmiten y el compromiso que establecen con los empleados estará directamente relacionado con su éxito durante y después de la pandemia.

Spain , Jul 6, 2020

Seguridad y Gobierno en escenarios DevOps

Nuestro objetivo es ayudar a las organizaciones a implantar una cultura de DevSecOps rápidamente en lo que se refiere al Pipeline de desarrollo y CI/CD.

Spain , May 19, 2020

¿Qué es la gestión de amenazas? Desafíos comunes y mejores prácticas

La base de la gestión de amenazas es una integración perfecta entre personas, procesos y tecnología para anticiparse a las amenazas.

Spain , Mar 6, 2017

El sistema de información de marketing perfecto

Descubre las principales ventajas, inconvenientes y aspectos a considerar al construir un sistema de información de marketing que aporte valor al negocio.

Spain , Aug 24, 2015

Inteligencia de Clientes: identificar preferencias y segmentación

La inteligencia de clientes es un área clave, por ello el uso de herramientas BI ayudan a identificar las preferencias de los consumidores y segmentarlos.